Генеральный директор Nvidia Дженсен Хуанг начал конференцию GTC с обновления своего суперкомпьютера DGX на базе 8 графических процессоров H100, которые работают вместе как один графический процессор.

Также были представлены два новых графических процессора, которые помогают делать выводы в генеративной работе ИИ.

На волне ChatGPT

Nvidia, очевидно, рассчитывает нажиться на увлечении ИИ, вызванном ChatGPT, с помощью графических процессоров с возможностью вывода, а также программного обеспечения и услуг, о которых компания объявила на своей конференции GTC во вторник.

Принимая во внимание тот факт, что ChatGPT стал массовым за несколько коротких недель в конце прошлого года и достиг 100 миллионов пользователей, что является самым быстрым ростом среди всех приложений, генеральный директор Дженсен Хуанг добавил: «Мы находимся в моменте появления ИИ для iPhone».

«Есть много замечательных гиперскейлеров и стартапов, которые надеются стать следующим Open.Ai, — сказал в интервью Fierce Ян Бак, вице-президент подразделения ускоренных вычислений Nvidia.

«Вот почему мы хотим поддерживать возможность логического вывода, а не только обучения. Вывод — это очень увлекательно».

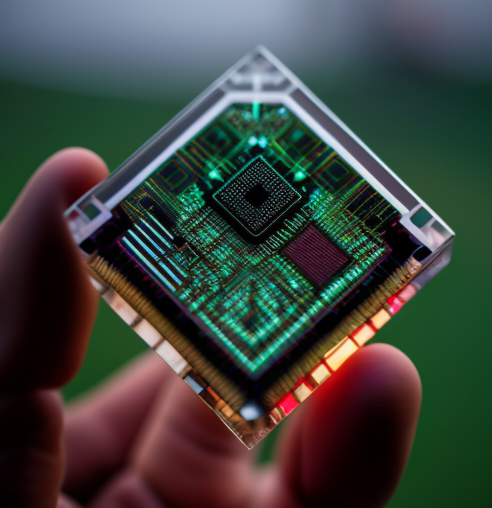

Два новых чипа для работы с выводами

Компания анонсировала два новых чипа для работы с выводами: L4 для графического процессора видео AI, который сейчас находится в закрытом предварительном просмотре в Google Cloud и через 30 производителей компьютеров, и H100 NVL с двумя графическими процессорами NVLink для больших языковых моделей, ожидается во второй половине 2023 года.

Однако объявления GTC в течение недели будут больше, чем просто чипы, наряду с новыми партнерствами и программными библиотеками.

Новые графические процессоры являются частью набора из четырех конфигураций логического вывода от Nvidia, включая L40 для генерации изображений, который теперь используется в качестве движка Nvidia Omniverse.

Nvidia Grace Hopper

Четвертой платформой, ориентированной на логические выводы, является Nvidia Grace Hopper для рекомендательных моделей, векторных баз данных и графовых нейронных сетей.

Ранее сообщалось, что Grace Hopper представляет собой суперчип, сочетающий в себе центральный и графический процессоры, и в настоящее время его образцы будут запущены в производство во второй половине 2023 года, а в первой половине 2023 года ожидается отставание от более раннего производства.

Четыре платформы логического вывода Nvidia слева: L4 для AI-видео (новая), L40 для генерации изображений, H100NVL для LLM (новая) и Grace Hopper для рекомендательных моделей.

Было раскрыто несколько деталей нового кремния.

H100 NVL основан на уже готовом графическом процессоре H100, который включает в себя Transformer Engine для обработки таких моделей, как модель GPT в Open. ChatGPT ИИ.

Open.AI использовал HGX A100 для обработки GPT-3, но Nvidia заявила, что стандартный сервер с четырьмя парами H100 и NVLink с двумя графическими процессорами работает в 10 раз быстрее.

Последняя версия суперкомпьютера Nvidia DGX оснащена восемью графическими процессорами H100, соединенными между собой межсоединениями NVLink, а также сетями Quantum Infiniband и Spectrum Ethernet, и в настоящее время находится в полном производстве.

Он обеспечивает 32 петафлопса вычислений.

Nvidia назвала OpenAI заказчиком H100 на своем суперкомпьютере Azure, наряду с Meta, Stability.ai, Twelve Labs и Anlatan.

Хуанг заявил, что H100 может снизить затраты на обработку LLM на порядок. Кроме того, H100 NVL может значительно сократить общую стоимость владения, добавил Бак.

По его словам, два графических процессора H100 NVL, работающие вместе с NV Link, могут уменьшить задержку для логических выводов и могут подключаться через PCIe, который широко распространен в серверной индустрии.

Рассмотрены вопросы снабжения

В то время как некоторые в отрасли беспокоятся о достаточном количестве графических процессоров для поддержки растущей работы ИИ, Бак сказал, что «нет проблем» с поставкой кремния от его основного завода, TSMC. «Мы полностью заняты Хоппером», — сказал он, имея в виду сокращение для H100.

«Тем временем мы продолжим выводить на рынок A100, который уже развернут и пользуется большим спросом, который мы продолжим наблюдать в этом году. Безусловно, спрос высок по мере развертывания графических процессоров».

Бак добавил, что иногда клиентам сложно получить доступ к графическим процессорам, особенно если клиенты являются новичками в области ИИ и ищут графические процессоры по запросу, в то время как контракты на резервирование от других клиентов выполняются в первую очередь.

С Hopper любые задержки связаны только с выходом чипа на рынок. «Там очень много инженеров, и это масштабное наращивание сети, стоек и кабелей, чтобы затем квалифицировать это и убедиться, что оно работает», — добавил Бак.

«Гипермасштаб — это вызов. Хоппер только сейчас выходит на рынок. На A100 был очень большой спрос. По мере того, как они внедряются в центры обработки данных, они поглощаются, и мы строим их так быстро, как только можем».

В то время как Бак отмахнулся от каких-либо проблем с получением графических процессоров от TSMC, аналитик Дилан Патель из SemiAnalysis сказал Fierce, что в настоящее время «огромный дефицит графических процессоров Nvidia и сетевого оборудования от Broadcom и Nvidia из-за резкого скачка спроса».

По его словам, обе компании быстро набирают обороты, но все еще существует большой разрыв, поскольку сроки выполнения заказов в один год различаются в зависимости от продукта.

По словам Патель, самые большие узкие места в поставках связаны с CoWoS, памятью с высокой пропускной способностью и сетевыми продуктами, причем все они имеют разное время выполнения заказа.

CoWoS — это сокращение TSMC от Chip-on-Wafer-on-Substrate, тип интегральной схемы для высокопроизводительных вычислений.

Первоначальная реакция на новости GPU

Пател сказал, что H100NVL «идеально подходит для вывода таких моделей, как Chat GPT 3.5 turbo».

Использование графических процессоров 2H100 с высокоскоростным NVLink «делает их похожими на один гораздо более быстрый графический процессор».

Что касается L4, Патель сказал, что это интересно, потому что изначально он будет поставляться Google, который делает свои собственные TPU в качестве конкурентов графическим процессорам.

«Тем не менее, Google все же обратился к Nvidia за чипом, который выполняет вывод для сетей видео и изображений», — сказал Патель.